AnythingLLM 구성¶

AnythingLLM은 자체 데이터를 사용하여 LLM과 상호작용할 수 있도록 설계된 풀 스택 애플리케이션입니다.

주요 기능

- 조직의 지식 기반을 활용하는 개인화된 챗봇 구축

- RAG (Retrieval Augmented Generation) 및 Knowledge Base 구축에 특화

- 다양한 LLM 백엔드 연동 지원

구성 목표¶

| 항목 | 구성 | 비고 |

|---|---|---|

| 디렉토리 | $HOME/lab/anything-llm |

start-anything-llm.sh |

| Docker | mintplexlabs/anythingllm:latest |

버전 1.9.1 |

| 접속 | http://[IP]:3001 |

비밀번호만 입력 (techax@@26) |

AnythingLLM 구동¶

1단계: Docker 이미지 다운로드¶

2단계: 실행 스크립트¶

~/lab/anything-llm/start-anything-llm.sh

#!/usr/bin/bash

docker stop anythingllm 2>/dev/null

docker rm anythingllm 2>/dev/null

SCRIPT_DIR=$(dirname "$(readlink -f "${BASH_SOURCE[0]}")")

export STORAGE_LOCATION=$SCRIPT_DIR/anythingllm_data

mkdir -p $STORAGE_LOCATION

touch "$STORAGE_LOCATION/.env"

docker run -d \

--name anythingllm \

-p 3001:3001 \

--cap-add SYS_ADMIN \

-v ${STORAGE_LOCATION}:/app/server/storage \

-v ${STORAGE_LOCATION}/.env:/app/server/.env \

-e STORAGE_DIR="/app/server/storage" \

--restart unless-stopped \

mintplexlabs/anythingllm

3단계: 실행¶

브라우저에서 http://[IP]:3001 접속

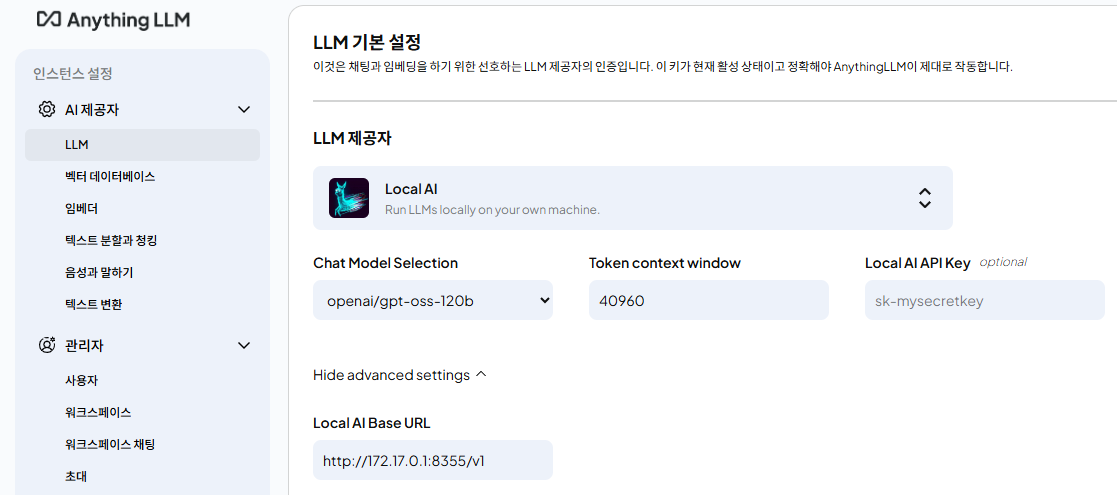

로컬 LLM 연동¶

vLLM 또는 TensorRT-LLM으로 구성된 gpt-oss-120b 등의 모델을 AnythingLLM과 연동할 수 있습니다.

설정 방법¶

- 설정에서 LLM 제공자로 Local AI 선택

- Local AI Base URL에 OpenAI 호환 API Endpoint 입력

- 정상 입력 시 Chat Model Selection 메뉴에 모델 이름 자동 표시됨

연동 점검¶

모델 선택 후 간단한 질문으로 연결 상태를 확인하세요.